Microsoft Fabric ist eine cloudbasierte Datenplattform. Sie kann Unternehmen dabei unterstützen, ihre Datenverarbeitung, -analyse und -integration zu vereinfachen und zu optimieren. Diese Plattform wird als Saas-Modell (Software as a service) bereitgestellt und sie integriert viele verschiedene Services und Technologien unter einheitlichen Benutzeroberfläche.

Die folgende Darstellung fasst die integrierten Services zusammen.

Architektur Microsoft Fabric

- Data Engineering mit Synapse: Eine Spark-Plattform zur Verarbeitung und Analyse großer Datenmengen.

- Data Warehouse mit Synapse: Eine Lösung für Speicherung und Parallelverarbeitung großer Datenmengen auf mehrere Rechenknoten.

- Data Science mit Synapse: Ermöglicht eine nahtlose Integration mit Azure Machine Learning.

- Echtzeitintelligenz: bietet Echtzeitanalyse zum Abfragen und großer Datenmengen (Mit KI) an.

- Data Factory: Ermöglicht Datenintegration und ETL-Prozesse (Extract, Transform, Load) aus einer Vielzahl von Datenquellen

- Microsoft Power BI: Ermöglicht die Visualisierung von Daten und das Erstellen interaktiver Dashboards.

- Data Activator: Eine No-Code-Umgebung für Überwachung und automatische Ausführung von Aktionen.

- OneLake: Ein zentrales Datenspeicherort für alle Organisationsdaten. Es vereinfacht die Verwaltung und gemeinsame Nutzung von Daten. OneLake basiert auf Azure Data Lake Storage zweite Generation (ADLS Gen2) und es ist hierarchisch aufgebaut.

Microsoft Fabric zielt darauf ab, die gesamte Datenpipline von der Datenextraktion über die Analyse bis hin zur Visualisierung in einer Plattform zu konsolidieren.

Heutzutage kombinieren Unternehmen in der digitalen Landschaft jedoch verschiedene Infrastrukturansätze oder Plattformen, um eine flexible und skalierbare IT-Umgebung zu schaffen, die Effizienz und Produktivität steigert.

Diese Architektur nutzt sowohl On-Premises Systeme als auch Cloud-Services und die Daten können aus heterogenen Systemen extrahiert werden.

Ein Beispiel für Datenextraktion zwischen heterogenen Systemen ist die Integration der SAP-Systemen ins Microsoft Fabric. Im Vergleich mit SAP Datasphere, der cloudbasierten Plattform von SAP für Datenmanagement und Analyse, bietet Microsoft Fabric mehrere Möglichkeiten der Integration von heterogenen Daten aus SAP-Systemen (SAP S/4HANA, SAP BW, SAP Datasphere).

In diesem Blog wird erläutert, wie die Daten aus SAP-Systemen in Microsoft Fabric integriert werden können.

Allgemeine Voraussetzungen

Um Daten aus einer SAP-Quelle bzw. OnPremise Quellen zu extrahieren, muss die Software-Datengateway installiert werden. Das lokale Datengateway ist eine lokal installierte Windows-Clientanwendung, die als eine Brücke zwischen den Datenquellen und den Diensten in der Microsoft-Cloud dargestellt werden kann. Sie bietet eine schnelle und sichere Datenübertragung. Das Gateway funktioniert mit mehreren Diensten, zum Beispiel Azure Analysis Services, Azure Data Factory, Azure Logic Apps, Microsoft Fabric, Power Apps, Power Automate und Power BI. Herunterladen des Standardgateways

Integration von SAP-Quellen in Microsoft Fabric

Das folgende Kapitel beschäftigt sich mit den Anbindungsmöglichkeiten von SAP-BW und S/4HANA an Microsoft Fabric.

SAP BW

Anbindung SAP BW-Applikationsserver an Microsoft Fabric per Power Query

Mit Power Query kann eine Verbindung zu einem SAP BW-Applikationsserver hergestellt werden und die Daten können ins Microsoft Fabric extrahiert werden. Mit einem Datenfluss vom Typ Dataflow Gen2 können die Daten ins Microsoft Fabric integriert werden.

In der linken Seite der Abbildung wurden die auf dem Server verfügbaren Objekte aufgelistet. Der Katalogordner mit dem Namen $INFOCUBE enthält Alle InfoProvider, die im SAP BW-System verfügbar sind. Die anderen Katalogordner stehen für InfoProvider im SAP BW, für die mindestens eine Query existiert.

Anbindung SAP BW-Applikationsserver an Microsoft Fabric per Power Query

Als alternative Option können Daten aus einem SAP BW-Applikationsserver in Microsoft Fabric mit Azure Data Factory (ADF) unter Verwendung der Datenpipeline integriert werden. Die Daten können in Microsoft Fabric integriert werden mit einer Zwischenspeicherung der Daten in einem Azure Data Lake (ADLS). Im Azure Data Factory (ADF) kann eine Pipeline erstellt werden, die die Daten aus SAP BW-Applikationsserver extrahiert und im Azure Data Lake ablegt. Microsoft Fabric kann direkt und nahtlos mit Datenquellen wie Azure Data Lake (ADLS) verbunden werden und auf Daten zugreifen und sie extrahieren.

SAP BW

Anbindung SAP S/4HANA an Microsoft Fabric mit Datasphere Replication Flow

Im Folgenden wird gezeigt, wie die Daten aus einem SAP S/4HANA-System in Microsoft Fabric mithilfe von Replikationsfluss in SAP Datasphere integriert werden können, ohne sie in SAP Datasphere zu speichern. In diesem Fall spielt Azure Data Lake Gen 2 die Rolle eines Zwischenziels bzw. eines Speicherortes, wo die Daten repliziert werden können.

In unserem Szenario gehen wir davon aus, dass in Ihrem SAP Datasphere-System bereits eine Verbindung zu SAP S/4HANA und Azure Data Lake Gen 2 vorhanden ist. Mehr Informationen über die Verbindungen zur Azure Data Lake Gen 2 finden Sie über den folgenden Link: Verbindung zur Azure Data Lake Gen 2

Im Data Builder in SAP Datasphere kann ein Replikationsfluss erstellt werden. Als Quelle kann eine CDS-View aus dem Ordner „CDS – CDS Views“ ausgewählt werden und als Ziel wird ein Azure Data Lake Gen 2 Objekt Store Container definiert. Der Pfad „/data“ stellt der Ordner dar, wo die Daten aus dem SAP S/HANA System repliziert werden. Dieser Pfad bzw. Ordner wird in der Azure Data Lake Storage (ADLS) im Zielcontainer angelegt. In diesem Ordner werden die Daten im Parquet Format gespeichert.

Die Datenspeicherung in einem Azure Data Lake Storage (ADLS) Konto ermöglicht Microsoft Fabric einen einfachen Zugriff und reibungsloses Laden von Daten. ADLS ist eine gute Option für die Zwischenspeicherung, weil er hohe Kapazität und Performance für die Integration größeren Datenmengen bietet.

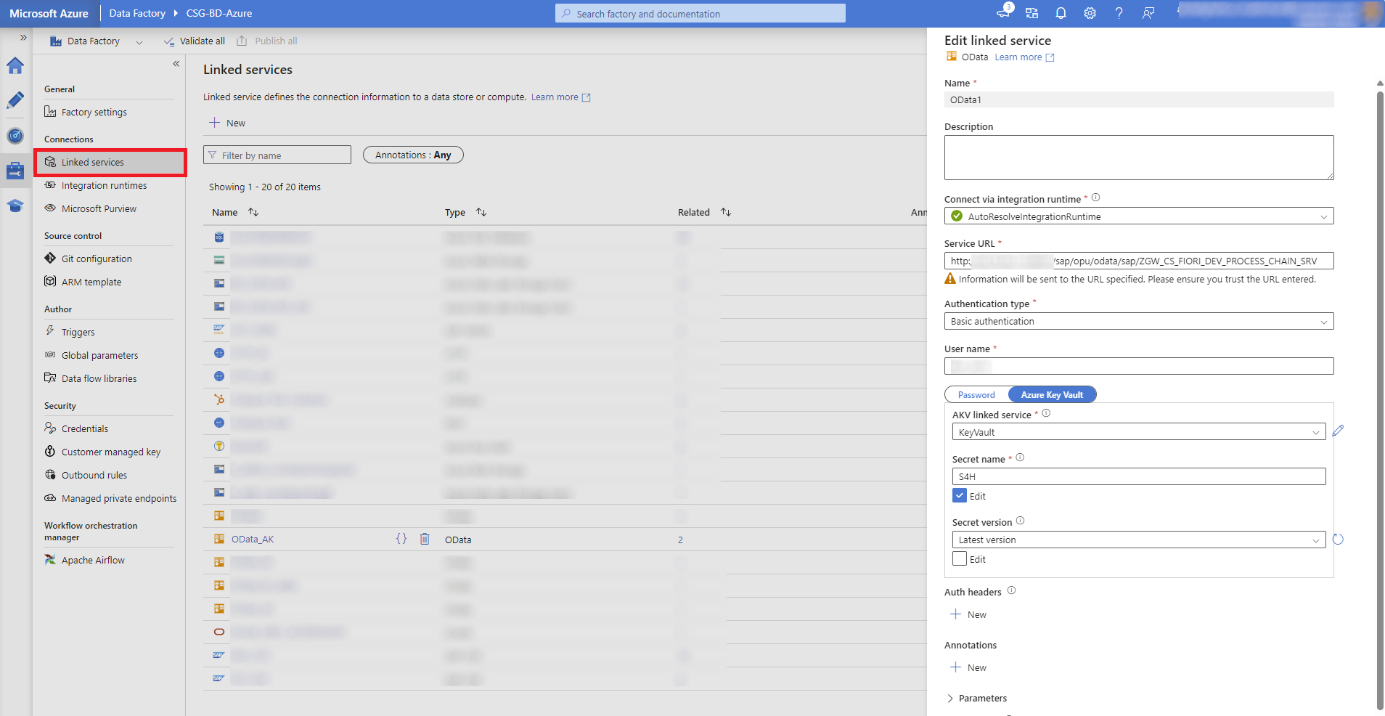

Anbindung S4/HANA an Microsoft Fabric über OData

Azure Data Factory (ADF) in Microsoft Fabric verwendet OData-Connector, um Dataflow Gen2 mit dem OData-Service zu verbinden. Mit diesem Connector kann der OData-Service in Azure Data Factory verwendet werden und ADF kann auf OData-Services in S/4HANA zugreifen, um die Daten zu extrahieren. Eine Linked Service-Verbindung für OData kann erstellt werden, dafür muss die Authentifizierungsinformationen (z. B. Benutzername und Passwort oder OAuth) angegeben werden.

Im Azure Data Factory und mit der Hilfe einer Pipeline können die Daten aus SAP S/4HANA-System über den OData-Connector geladen werden. Diese Pipeline kann so eingerichtet werden, dass sie inkrementelle Daten abruft oder die gesamte Datenmenge nach einem festen Zeitplan lädt.

Wie auch bei den anderen Szenarien wird ein Zwischenspeicherschritt benötigt. Daten aus dem SAP S4/HANA-System können im Azure Data Lake abgelegt werden. Die Daten können in ein Format transformiert werden (z.B Parquet), um die Performance in Microsoft Fabric zu optimieren. Im Microsoft Fabric kann auch konfiguriert, dass die Daten aus dem Data Lake regelmäßig aktualisiert werden, um sicherzustellen, dass die Berichte und Dashboards immer auf dem neuesten Stand sind.

Wir sehen, dass bei 100000 Datensätze bei allen Reports das Mess-Kriterium identisch ist. Bei 10 Mio. Datensätze wird aber bei Direkt Query V2 wesentlich mehr Zeit bis zur freien Navigation im Report benötigt.

Gesamtergebnis

Berechnen wir nun die Gesamt-Zeit, welche benötigt wird, um Daten (bei 250000 zu aktualisierende Datensätze) in diesem Bericht zu visualisieren, so kommen wir zu folgender Auflistung:

Fazit

Nach der Erläuterung der Microsoft Fabric und ihrer Möglichkeiten zur Extraktion heterogener Daten, insbesondere von Daten aus SAP-Systemen, kann zunächst davon ausgegangen werden, dass eine direkte Anbindung nur aus dem SAP-BW mit Hilfe von Power Query erfolgen kann. Dabei ist zu beachten, dass diese Methode im Vergleich zur Anbindung über Data Factory zwar einen einfachen Zugriff auf SAP BW-Objekte bietet. Sie kann jedoch in Bezug auf die Performance langsamer sein. Außerdem müssen bei der Übertragung der in Fabric erstellten Felder diese einzeln ausgewählt werden und funktionieren in einigen Fällen möglicherweise nicht korrekt und müssen angepasst werden.

Zweitens ist für die Anbindung von SAP S/4HANA ein Zwischenschritt erforderlich. Ein direkter virtueller Zugriff auf die Daten in SAP S/4HANA ist nicht möglich. Die Daten müssen in einem Data Lake (OneLake oder Azure Data Lake Storage) gespeichert werden. Der Data Lake ermöglicht die einfache Nutzung von ETL-Prozessen und eine Vielzahl von Datenanalysen und rechenintensiven Aufgaben für große Datenmengen. Im Data Lake werden die Daten in den meisten Fällen im Parquet Format gespeichert und Fabric kann problemlos darauf zugreifen.

Blogartikel

Möchten Sie tiefer in Integration von SAP-Daten ins Microsoft Landschaft eintauchen? Entdecken Sie in diesem Blog die verschiedene Konnektierungsmöglichkeiten des SAP BW an Microsoft Power BI:

Oder in diesem Blogartikel erfahren Sie, wie die Daten aus SAP Datasphere in Power BI konsumiert werden können.

Webinare

Im folgenden finden Sie weitere Webinare zum Thema:

Wenn wir Ihr Interesse im Bereich Analytics mit Microsoft Fabric geweckt haben, stehen Ihnen unsere Experten gerne zur Verfügung. Zögern Sie nicht, sich an uns zu wenden, um weitere Informationen zu erhalten oder individuelle Fragen zu klären. Wir freuen uns darauf, Sie zu unterstützen!

Vereinbaren Sie jetzt Ihren Expert Call. Wir freuen uns über Ihre Nachricht.

Abdelghafour Makhchan

Consultant SAP BW

- n.n.